|

| 1 | +# 01-大语言模型发展 |

| 2 | + |

| 3 | +## 0 大纲 |

| 4 | +AI大模型的相关的一些基础知识,一些背景和基础知识。 |

| 5 | + |

| 6 | +多模型强应用AI 2.0时代应用开发者的机会。 |

| 7 | + |

| 8 | +1. AI产业的拆解和常见名词 |

| 9 | +2. 应用级开发者,在目前这样一个大背景下的一个职业上面的一些机会 |

| 10 | +3. 实战部分的,做这个agent,即所谓智能体的这么一个虚拟项目,项目需求分析、技术选型等 |

| 11 | + |

| 12 | +## 1 大语言模型发展 |

| 13 | + |

| 14 | + |

| 15 | + |

| 16 | + |

| 17 | + |

| 18 | +LLM,Large Language Model,大语言模型。为什么叫2.0?因为在大语言模型,也就是LLM出现之前,我们把它归结为1.0时代。那么1.0时代主要的是NLP(自然语言处理)的各类工程,它其实都是一个特点,就是说通用性比较差。那么整个AI领域的终极的圣杯,或者说将来它的一个终极的一个希望做到的,是AGI(Artificial General Intelligence,人工通用智能)。1.0可能是一个单任务的这么一个AI。比如深蓝战胜象棋冠军,他只会下象棋,而且他的下象棋是学习了很多的这个象棋的这个国际象棋的这个套路,他只会干这一个事情,而且你问他别的事情他肯定不知道。 |

| 19 | + |

| 20 | +## 2 LLM的特点 |

| 21 | + |

| 22 | +大语言模型的特点是啥?大语言模型,它就是说可以像语言一样跟我们交互,那么通过语言,它其实可以扩展到很多的场景。那么未来呢,可能会从依据大语言这种方式,我们可能会发展出来真的发展出来AGI,所谓的通用智能,也就是跟我们人类一样拥有智慧的这样的一个智能体。那好,那我们1.0我们AI 1.0我们就不做介绍了,那里面其实有很多NLP的相关的东西。 |

| 23 | + |

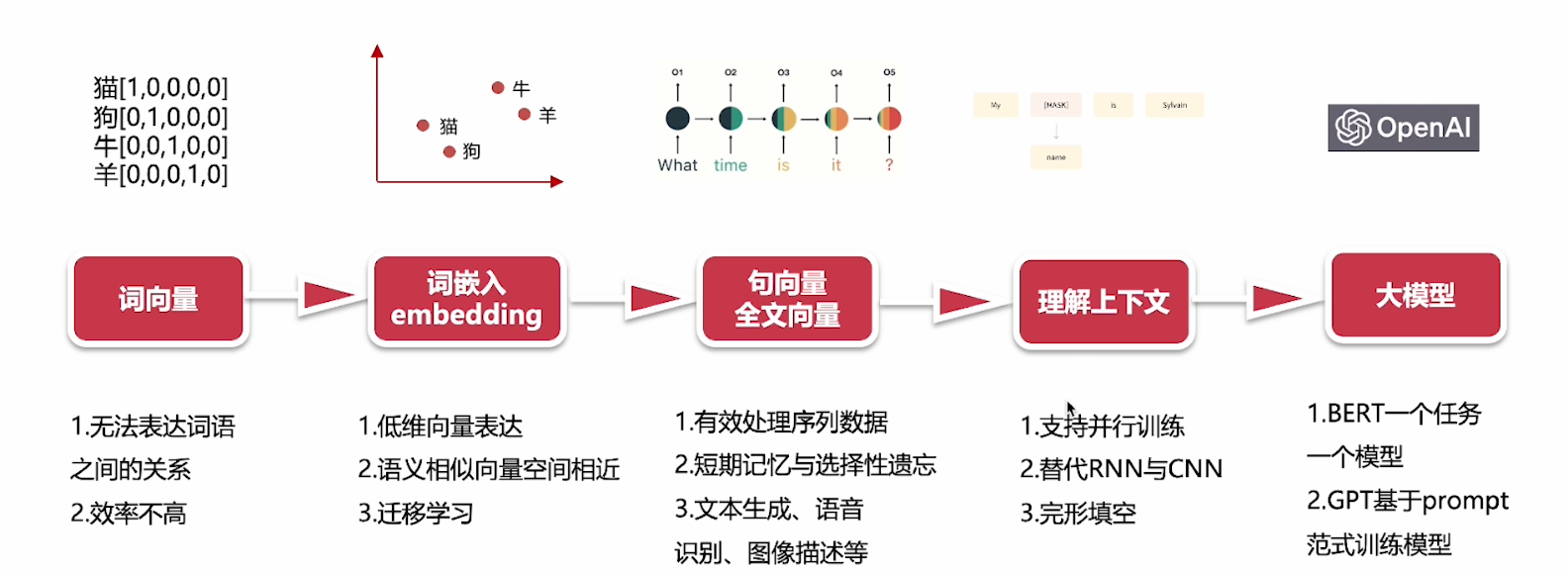

| 24 | +2.0开始介绍,技术层面基本上是一个从点到面的一个过程。那么最早出现的一个技术,是词向量技术,把自然语言的词语,使用向量来表示。向量是一个数学概念,比如猫,这个词在向量空间里面,它可能就表示成这样一个坐标位置。狗可能就跟它有所区别。牛又不一样。所以可理解为,每一个词,它在向量空间里面都有一个唯一坐标,然后就可构成这样的一个词语字典。然后使用这种one-hot的方式来表示,如苹果标注成101这样的坐标。把自然语言,通过数学语言去给它描述出来,而且它是一个坐标,可精准找到它位置。 |

| 25 | + |

| 26 | +## 3 大模型的不足和解决方案 |

| 27 | + |

| 28 | +但有问题,它没有办法表达词语和词语之间的这个关系。比如猫1这样一个坐标,和狗这样01一个坐标,之间什么关系呢?不知道的。 |

| 29 | + |

| 30 | +第二就是效率不是很高。 |

| 31 | + |

| 32 | +后面发展中,在这个词向量的基础上,出现 |

| 33 | + |

| 34 | +## 4 词嵌入(embedding) |

| 35 | + |

| 36 | +也继续叫词向量也可以,就是对语言模型进行预训练。我们通过大量现有文章资料,让我们的这前面这些词向量,它具备语言信息。那通过了一些训练的预训练之后的这个词向量,它在这个向量空间上,它就带上了一些额外的信息,它就会有效提升我们模型的效果。而且在后续的其他任务中间,去做一个迁移。那么这个就是大语言模型的预训练的这个,一个初始的一个原型。 |

| 37 | + |

| 38 | +比如猫、狗,通过坐标标注,让它有这种低维向量的这种这种表示。还可有这样语义相似的一个向量空间相近,好比我们认为,比如说猫和狗,通过我们的预训练的这些大量的文章,资料,我们发现猫和狗都同属于宠物。那么有可能这两个坐标点,在向量空间里就是比较接近。比如说我们找宠物的时候,那么在这个向量空间里面,猫和狗就是在宠物这个向量域里面。牛和羊,都属于我们的常用的肉吃的家畜,那可能就是在那个向量域里面。所以呢,我们可以看到词向量,它就是一个地位向量表示,再一个是语义相似的向量空间,相近的这么一个特性。还有一个,它可以迁移学习,把这个任务,迁移到其他任务里面去。深蓝的下象棋例子,就可以把它的技能去迁移啦。 |

| 39 | + |

| 40 | +在词嵌入之后出现 |

| 41 | + |

| 42 | +## 5 巨向量和全文向量 |

| 43 | + |

| 44 | +根据这个前文信息,去分析下文或根据本文翻译成另一种语言。那么它代表的呢,是一些模型,如: |

| 45 | + |

| 46 | +- RNN(Recurrent Neural Network,循环神经网络) |

| 47 | +- LSTM(Long Short-Term Memory,长短期记忆网络) |

| 48 | + |

| 49 | +它可有效处理这种时序性的,序列数据。"What time is it?",训练时,它是一层一层的,它第一层这个神经网络,可能先看到"What",然后"time","is","it",看到最后的问号。它会通过这样的一个顺序,去处理这样的一个语句,去做一个上下文的一个理解。它还可以做到一些短时记忆和选择性的遗忘,就是RNN和LSTM,那么它主要应用在像文本生成啊,语音识别啊,图像描述等等。这个时候就是比如说类似RNN和LSTM这样的模型出现的时候呢,它其实已经可以做到我们常见的一些AI识别。 |

| 50 | + |

| 51 | +再往后就到理解上下文,就是全文的上下文,如"买什么 什么is"这个这个模式理解上下文,这个模式代表作是类似比如说这个BERT这样大模型。到这阶段,已经可完成类似完形填空任务。那它就是根据上下文理解当前的代词,比如说男他女她动物它是什么,完成这个完形填空。那么这个时候就属于所谓的真域训练模型时代开启。 |

| 52 | + |

| 53 | +### 特点 |

| 54 | + |

| 55 | +支持并行训练,如说CNN(Convolutional Neural Network,卷积神经网络)这个模型比,就比如说这个"What time is it",只能一层一层处理,不支持并行训练。必须完成这个事情之后再做下一个事情。 |

| 56 | + |

| 57 | +所以呢,它替代RNN和CNN这样神经网络,更强大,可以实现一些类似语义识别。 |

| 58 | + |

| 59 | +最后就是OpenAI这GPT(Generative Pre-trained Transformer)出现,这个模型出现为代表,我们就正式进入了这种超大模型和模型统一的时代。从谷歌T5(Text-to-Text Transfer Transformer)这个模型开始的时候,它是引入了的这样的一个模式来训练模型。也就是说,它是把提示词告诉模型,然后把答案训练出来,然后不停的用这样的模式来训练模型。那么当我们在问模型这些问题的时候,其实也是通过,通过提示词,通过prompt的方式来引导它。所以到这个时代的时候呢,那我们以chatgpt为代表,我们发现它的效果非常惊艳。最新的成果就是说,我们的大模型已经支持了多模态,OpenAI开启的这个大模型时代呢,它其实是把这个,一种基于的这种训练模型这种方式提了出来。 |

| 60 | + |

| 61 | +所以我们为什么开始一讲就是说,它整个的大模型的发展,可以说是从一个从点到面的这么一个发展过程。大家知道理解就是它最核心,其实最早的是基于这个词向量的这么一个技术。那么通过这个不断的发展到神经网络,到这种单线的,到并行训练,最后直到这样的一个大规模超大规模的这样一个训练集,实现了这么一个大语言的一个模型的发展。 |

0 commit comments